本站介绍

关于本站

Audio、Chat、Completions、Embeddings、Images、Moderations接口均已支持,路径、参数和OpenAI的保持一致,这里仅列出一些平台自定义且公开的API文档,具体OpenAI兼容接口请查阅官方文档:https://platform.openai.com/docs/api-referencehttps://api.openai.com,或者在后面拼接一下文档中的路径即可。稳定、美国本土调用推荐、大陆不可用: https://api.ohmygpt.com稳定、快速CDN、非美国地区推荐、全球加速(大陆不可用): https://apic.ohmygpt.com大陆地区调用推荐、稳定: https://c-z0-api-01.hash070.com优质线路: https://www.aigptx.top优质线路: https://cn2us02.opapi.win而使用流式调用API接口时则不会受到Cloudflare的这个限制的影响。

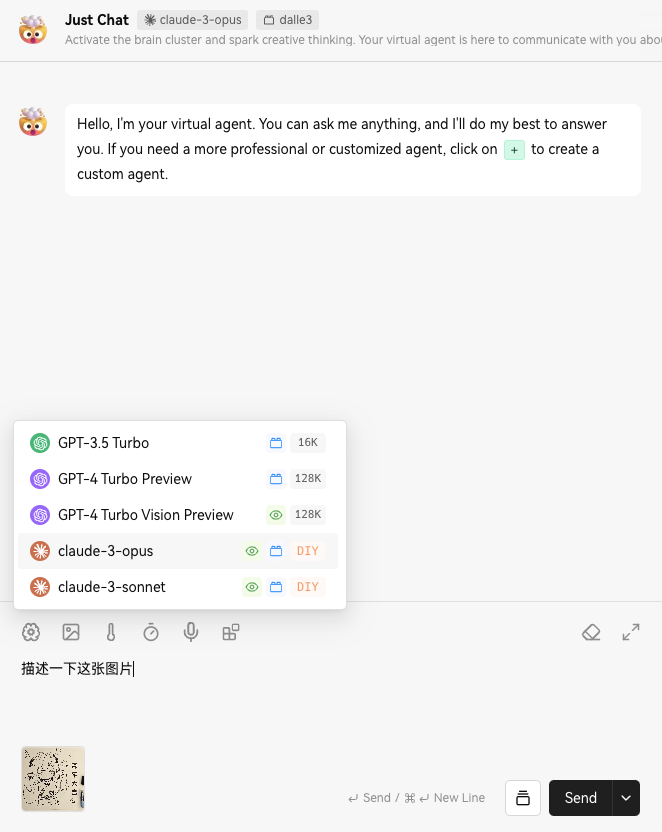

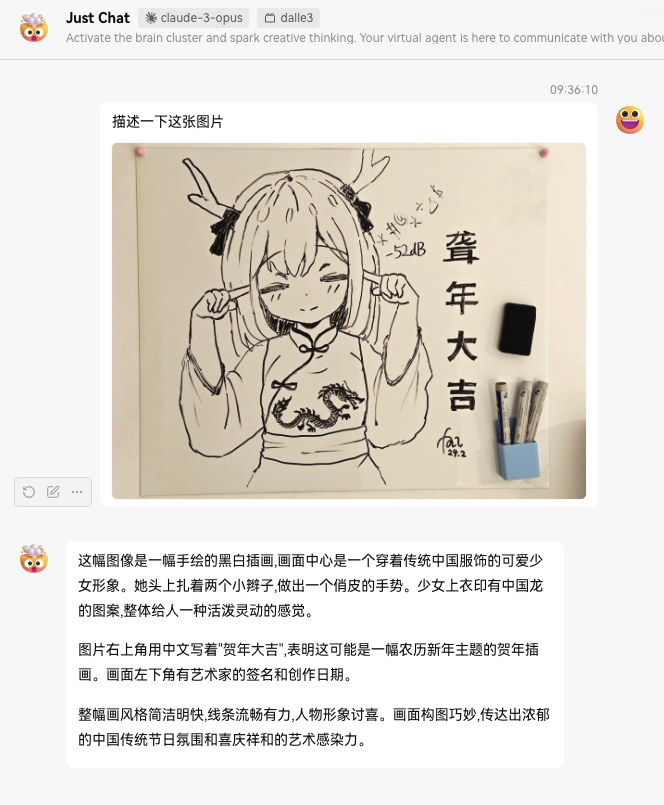

如何使用带图像输入的多模态模型?

vision

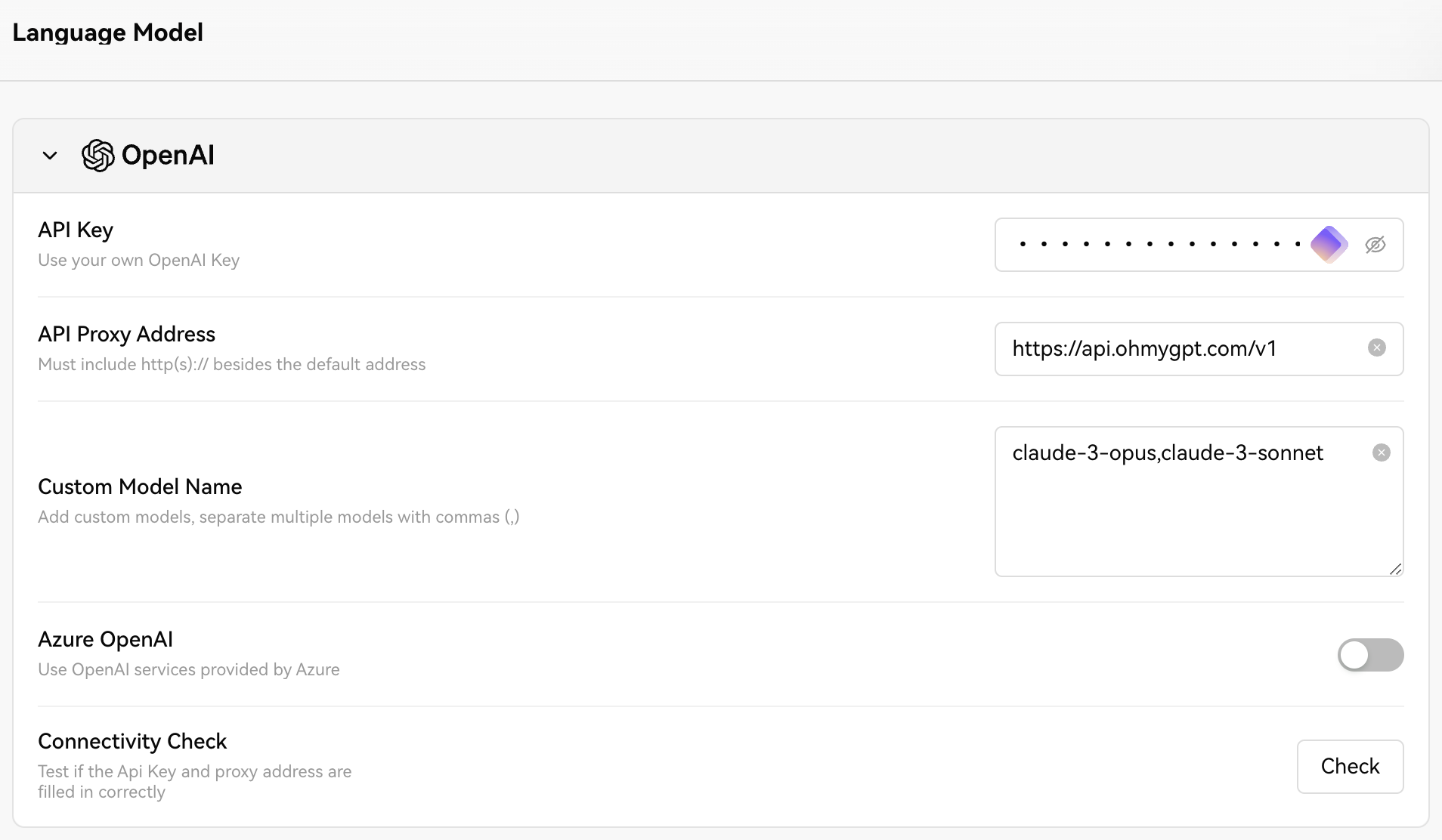

LobeChat

https://api.ohmygpt.com/v1claude-3-opus,claude-3-sonnet

BotGem(AMA)

在本站能否直接使用自己的openai的key?

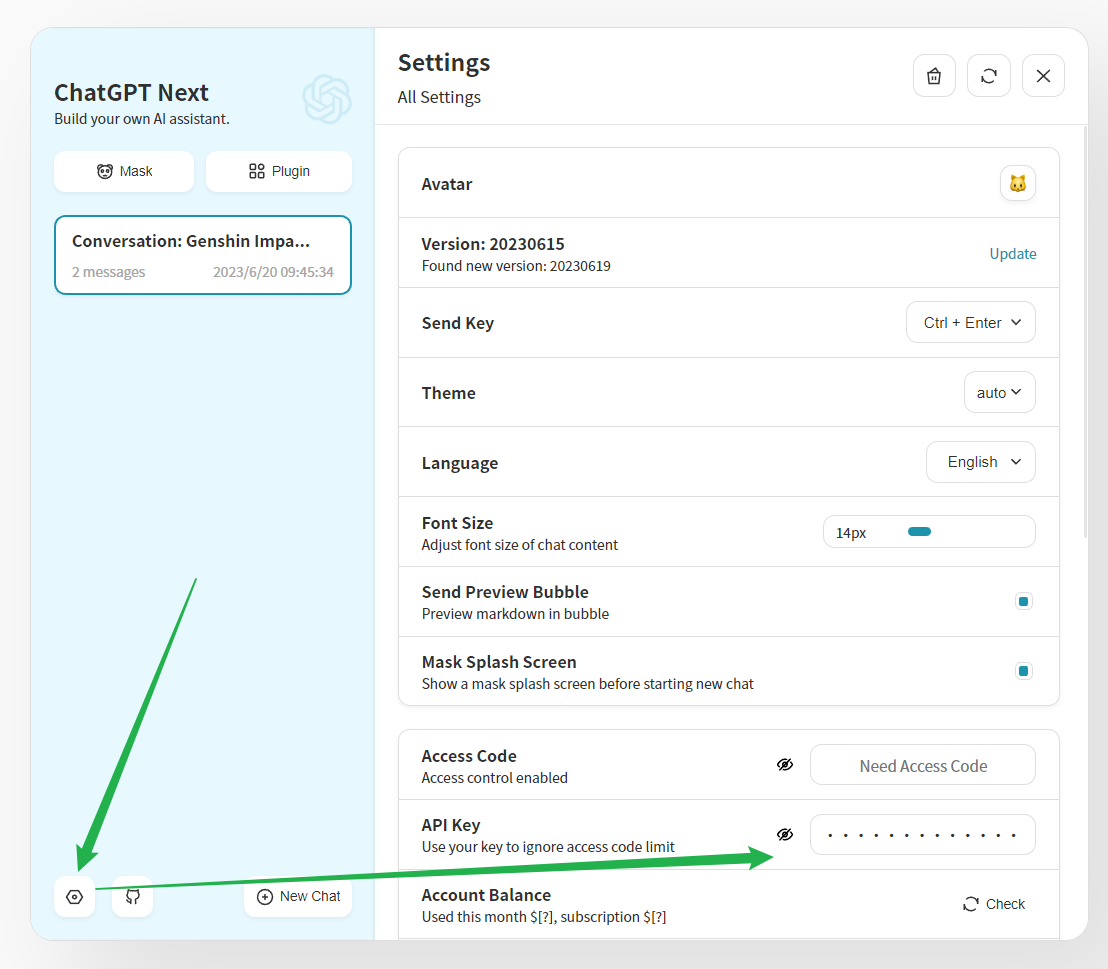

我如何在chatGPT-next-web中使用本站的服务?

我如何在GPT学术优化中使用本站的服务?

1.

2.

{"https://api.openai.com/v1/chat/completions": "https://aigptx.top/v1/chat/completions"}我如何在GPT学术优化中使用本站的Claude2服务?

1.

2.

{"https://api.openai.com/v1/chat/completions": "https://aigptx.top/v1/chat/completions"}3.

4.

5.

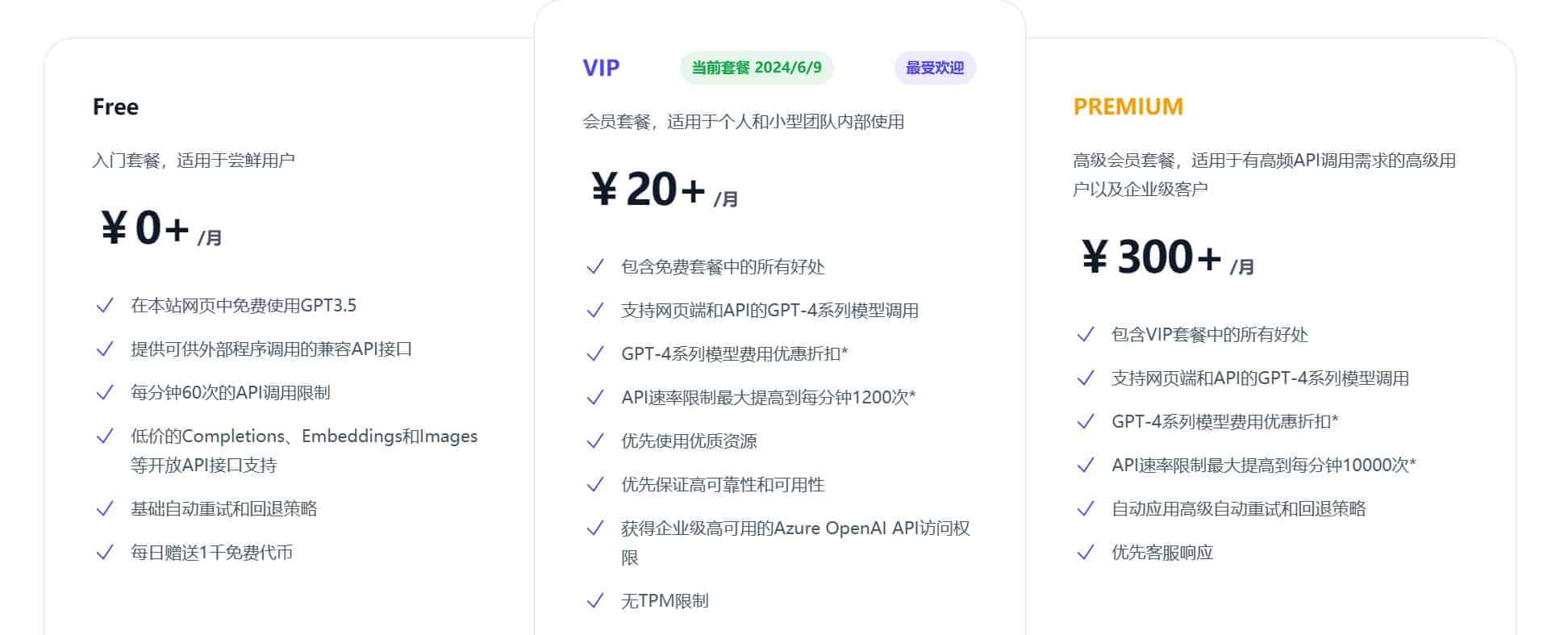

关于会员和GPT4

我该如何获取GPT4的使用权限?

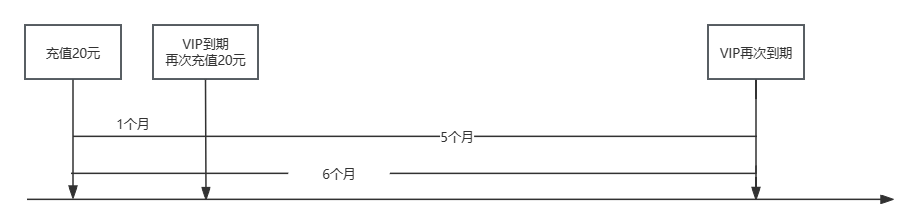

VIP套餐是否属于包月套餐?

我在充值20元后VIP资格过期了,再充值20元可以获取多久的VIP权限?

我无法访问OhMyGPT.com,是网站服务挂掉了吗?

https://status.ohmygpt.com/status/main

或者

https://status.aigptx.top/status/main

关于费用消耗

如何计算费用的消耗?

账单表中的每一列分别表示什么?

promptTokens和completionTokens是什么?

使用网页版时,为什么promptTokens会非常多?

网页版中为什么除了用户、模型之外还有一个系统角色?

关于API

我是新手,能否给出一个调用服务的代码示例?

首先,您需要准备您的key

修改于 2025-10-07 07:01:13